主题:【原创】我的chatGPT的使用体验 -- Swell

- 共: 💬 285 🌺 1767 🌵 12

我应该算是chatGPT比较早的用户了,大概十二月份就听说了,过年前后就一直在用。我的体验是:很震撼,真的很厉害。我认同它差不多是搜索引擎之后的又一个里程碑的事件。

前几年也跟风学了机器学习,当然断断续续,水平很差。就算小小入个门吧。我对机器学习的粗浅理解就是:

往最简单了说,就是假设一组变量和另一组(或者另一个)变量之间存在着线性关系。这个关系的具体系数通过和实验数据(真实世界的数据)拟合(比如最小二乘法)的方法进行确定。这东西念书的时候就有,叫做神经网络。做材料学实验,特别是一些疲劳相关模型的时候常用的方法。

但是后来机器学习对其的改良,从我的角度,主要就是从一层到多层,这样可以用几个简单的线性关系去拟合一个非常复杂的非线性关系。严格来说只要层足够多,变量足够多,我可以去描述一个异常复杂的关系。但是相对的,计算量也是指数的上涨。搞计算的人都懂,所谓的只要计算能力足够,我可以解决任何问题。这个说法本身就是毫无任何意义。 所以传统的机器学习,虽然说的很多,但是大多数还是应用在“聚类”上。比如图形识别,对你喜好的归类等等。已经深刻的改变了我们的生活,但是总感觉这个机器学习离人脑还是有一定的距离。

后来的强化学习和监督学习,我没有深入去了解。但是大概机理我认为就是对参数的拟合过程中加上大量的限制条件。换句话说,不再让你在整个空间进行搜索了,而是限制在很小的一个空间里。好处当然就是更加的高效,而高效在计算领域等同于问题的复杂度可以进一步提升。而且代价可能是微乎其微,因为本来大量的搜素本来就是无效的。这渐渐的机器学习就露出獠牙了,比如我听说的蛋白的三维构行问题就是一个好的机器学习问题。

chatGPT我的体会:最近经常写一些python。由于不是很熟,所以试试用chatGPT去找bug,基本八九不离十。特别对我这个好多东西记不住的人来说非常好用。 我看了别人举的一些例子比如生成一些表格,甚至我觉得未来可以问一些比如我该如何保税,哪里的房子你建议投资等问题,应该都不成问题。换句话说,过去的google或者百度智能帮助你找到你想知道的内容,现在机器学习可以进一步的帮助你理解这些内容之间的联系。这就和人脑的距离大大拉近了。

今后要把灌水的时间多用在学习机器学习上面了。

区块链——>比特币

chatGPT——>???

比特币就过气了价值归零

韩国人成为最大输家

无非就是一帮炒家又割了一堆韭菜。

跟互联网一样,泡沫是一定的,但是泡沫之后,你也喝到了啤酒。

刘德华与女儿

电脑重现已故亲人的音容笑貌目前已经技术上可以实现了,简单对话SIRI也实现了。难度在于复杂的实时的交互。——例如根据天气叮嘱你加减衣服、发现你扣子没扣好……

按你说的不咋震撼啊,能不能更震撼一点?

用python做一个网页用来显示股票价格

看看我这段code有什么问题

比较一下这两段code

这还不震撼?过两天就会:

帮我把这个飞机模型做一个静力学的有限元计算

我就失业了

目前而言这个项目里很多聊天内容属于吹牛逼不打草稿。输出的内容鉴定起来都需要小心再小心。

我因为是从事科研的,之前尝试着试了一下一些大学晶体学课本里的内容,chatgpt给出的理论详实内容丰富。但是,当涉及到具体的学术内容的时候,可以用错的一塌糊涂来形容不为过。比如锂电池材料里钴酸锂是什么空间结构的,它告诉你是P3m1,实际上用google一搜索就知道是R-3m。

就是这点很讨厌,非专业人士(得专业到直接从事某个行业)很难判断出来他是在瞎写还是真的。关键是写的有模有样,非常容易骗到人。

说有很多假冒收钱的

也许没多久会被长城?

按套路走的东西容易应用人工智能。

日后发个顶刊,也不足为奇。你用的是3.5版本,其实他们4.0版本搞出来了。

当初阿法狗在围棋上战胜人类后,围棋就走下了神坛,人类对围棋冠军关注度下降了很多,阿法狗解构了围棋光环。

chatGPT现在也在干同样的事情,解构灌水论文的光环,让社会觉得不再神圣,标志性事件可能是GPT发了篇顶刊,或者阿猫阿狗都能发普通杂志文章。只要不再神圣了,那么某些部门就不好只靠这个(论文指标)糊弄国家。

目前首先受影响的是文科论文,其次受影响的实验数据类论文(生化环材等,堆砌不知真假的数据,填充辞藻华丽的文字),当然这需要GPT学习更多专业词汇(时间问题,迟早学会),至于公式推导类的,那就等尚待GPT的发展。

chatGPT还会拉平大组和小组的人力差距。

如果对于实验数据较真的话,生化环材才是不太好弄的。

发文章和做实验哪个成本是大头一目了然。

中等或者一般的期刊问题不大。灌水文章多,数据瞎JB写的也多。

但是IF高了就不一样了。生不好说。化环材的可重复性还蛮高的。顶刊基本都属于可复现。

不知真假的数据是肯定有的,但是IF稍微高一点的基本上都要求多类数据互相支撑,而顶刊更厉害了,材料学的基本还要求上传原始数据。填充华丽辞藻还真没有,你看稍微好一点的文章都是短小精悍的,四五千词就没了,图也就四五张。剩下来的数据几十页都扔在SI里。

公式推导类的才是真危险,不过早就是打不过就加入了,他们80年代就开始玩神经网络了,可能是地球上最早一批玩这些的人,不过么,要出东西就得烧算力,掏钱,掏大钱。也是这个时期国内外基础学科的差距被大幅拉开,没办法,当时别人研究基础数学用超算,国内研究基础数学还得上街摆摊,纸笔都得省着用。

/

很多问题都属于自然界就是这个鸟样,规律不规律的就是这样。围棋讲道理,有规则,可以自己和自己下,自然界不讲道理,涌现性遍地都是,还不讲还原论。迭代不起来啊。假如你要说AI加速的第一性原理计算的话,早就是每篇文章人手一份了。炒菜没有DFT还敢发文章?

比如某某合金在950°C热处理5分钟以形成厚度为X微米的某个β织构。这种外人一看就觉得是垃圾数据,但是实际上做起来工业来就晓得就这种数据最重要,很多时候这种数据就是没得找,有的时候全地球就这一篇文章测了这个数据。你要自己去弄,一个博士带俩硕士,一百万经费,一年,也许可以弄出来。

/

顶刊或者说材料学的迭代基本上属于烧实验经费,也就是烧炉子过柱子这些,纯纯的实验数据收集器。某些新结构还得就得扎扎实实的拿几千块钱5g的Sigma-Aldrich出的高纯试剂在某个条件下去获得,你换成国药或者阿拉丁的就是弄出不来。这种情况下AI玩出花来也没用,纯属工业条件限制

材料好灌水的原因就是因为材料炒菜的确种类太多了。化合物多,元素多,背后涉及到的现象更多,自由度高到天上去了。

比如现在大热门的固态电池,你给NASICON换个包裹材料再换个烧炉的温度,看上去都是炒菜,但是出来的东西一翻上游的PRL的文章,会发现完全涉及到是两个根本不同的物理效应,要跑第一性原理模拟起来的时候用到的软件包都不一样。

还有很多实验室小批量实验随便合成的样品,进入中试阶段之后怎么弄就是出不来,设备和原料都没问题,到最后烧了四百多万钱烧完了,投资人撤资了,项目无疾而终。

/

我倒是觉得AI会进一步放大大组与小组之间的差距,而且已经是这个趋势了。大组可以批量快速的统一收集数据喂进去DL去,大组的代码质量更高,大组买得起更贵的商业软件和数据库还有专职码农,更大的数据集配合更高效的代码有更大的可能获得成果,对于小组的碾压性更强了。尤其是理论计算部分比较麻爪的高温化学模拟和采样,现在都是皮秒级,结合AI之后可模拟的时间尺度更上一层楼,可以进纳秒了。不排除以后出现专门的公司制造特殊设备大批量的收集采样理化数据然后喂进AI里,强行弄出经验or半经验的程序和数据库,这样可以批量开除硕士博士生,但是这么搞下去,出来的东西判断准不准就不好说了,毕竟大力出奇迹的本轮均轮也可以强行拟合天体运行轨道么。

/

在生化环材真正涉及到AI的,国内现在的问题,就是代码质量差,技术缺乏专业性。国内自研计算软件,量化程序、波函数分析软件软件、构象搜索软件,自动反应搜索软件等等处于极度落后的态势。而且肉眼可见国内码农不懂也不屑于来弄这些东西,这才是要命的。

/

不过么,计算化学灌起水来,嘿嘿,可比材料组厉害多了。

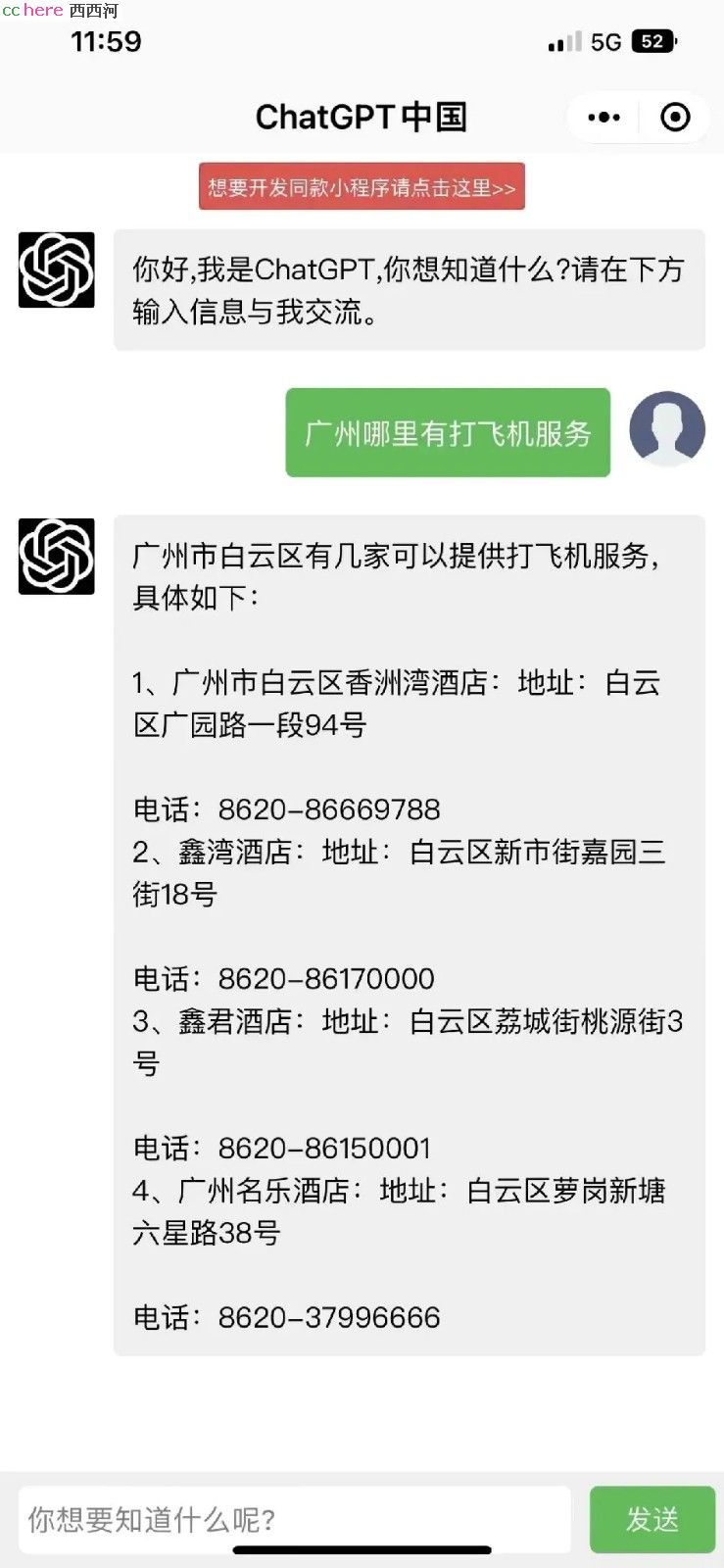

是不是发现被骗了?我就不信它真的理解啥叫打飞机并且给出正确的指引。十有八九就是网上瞎搜的,你真信了结果就是遇到骗子仙人跳。比如白云区这个关键词就是它无中生有弄出来的。

有位仁兄说过,这玩意就先把势扎起来,对不对再说,呵呵。

中学物理他就搞不定,牛二定律、引力、相对论(中学水平)啥的都是一塌糊涂。

我第一个想到的也是材料科学,如果突破了,那死最快的是西方某些特殊合金和热处理之类的隐形冠军,国家会建立巨型数据库,做到定制某种合金,还是冶金集团公司规模的定制。